Что за TOF камера в смартфонах? Это именно объектив или датчик? Для че.

Что за TOF камера в смартфонах? Это именно объектив или датчик? Для чего нужен?

И датчик, и объектив :-). Если обратиться к терминологии, то объектив это оптическая система, являющаяся частью оптического прибора, обращённая к объекту наблюдения или съёмки.

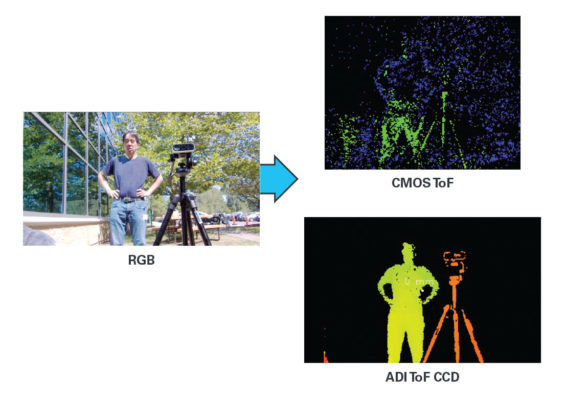

ToF-датчик (расшифровывается как Time of Flight, он же датчик глубины или времяпролетная камера) — это специальный сенсор, который излучает свет и регистрирует скорость его отражения от объекта. Зная время отражения, на основе скорости света (она постоянна в воздухе) можно вычислить точное расстояние до объекта, как это делает лазерный дальномер.

Таким образом, ToF-сенсор фиксирует не свет (как это делают обычные камеры для фотосъемки), а расстояние. Если измерить расстояние до разных точек, можно получить трехмерную картинку наблюдаемого объекта. И все это в реальном времени.

Сейчас датчики глубины популярны в смартфонах хуавей, хонор, оппо, самсунг и так далее. А первым смартфоном с такой камерой стал iPhone X в 2017 году. Именно для этого у него такая объемная «челка» — дополнительная ToF-камера стала ключевым элементом системы распознавания лица FaceID.

Для чего нужны датчики глубины? Пока что их применение ограничено, но перспективы большие. Реальное применение на данный момент — разблокировка по лицу, создание анимированный эмодзи на основе лица владельца телефона. В теории с такими камерами можно создавать вымышленных персонажей, которые будут похожи на своих «человеческих» прототипов и иметь живую мимику.

Также это позволит кому угодно делать комбинированные видеосъемки с «левыми» объектами, которые будут вести себя и располагаться в пространстве как реальные. Это полезно и для технологий дополненной реальности. Используется уже сейчас — например, можно онлайн примерить мебель к своей квартире. Или пририсовать виртуальные стикеры к каким-то вещам. Или играть в сетевую игру с виртуальными объектами, глядя на них через камеры ваших смартфонов. Вот ролик по теме от Sony с милым саундтреком:

Также ToF-камеры позволят создавать трехмерные модели объектов (например, для 3D-печати). Человек, сооружение, прибор — неважно. А комбинация обычной камеры и ToF позволяет получать такие модели в реальных цветах.

Датчик глубины резкости в смартфоне — что это и зачем нужно?

Особенности и использование сенсора глубины резкости в телефоне.

Датчик глубины резкости — это сенсор, который во время съемки на камеру определяет глубину и дальность расположения объектов относительно смартфона и друг друга. Обычно датчик является отдельным модулем в блоке камер телефона, но в более современных моделях его встраивают в другие типы объективов, например, в широкоугольные или телеобъективы.

Зачем нужен датчик глубины резкости в телефоне?

Единственная функция датчика глубины резкости заключается в преобразовании области, которая попадает в объектив камеры, в трехмерную карту. Предавая объектам размер и форму, датчик автоматически определяет их местоположение. Он понимает, какие предметы находятся ближе, а какие дальше. Таким образом сенсор может правильно определить глубину резкости, чтобы получился качественный снимок.

Отделяя объекты заднего плана от объектов переднего, датчик может создать эффект малой глубины резкости. Это означает, что большая часть изображения будет отнесена к заднему плану и размыта. В фокусе останется только небольшой объект в центре фотографии: человек, предмет на столе и т.д. Этот эффект дает ощущение, будто изображение было сделано на профессиональную камеру или тщательно обработано редактором фотографий.

На практике, датчик глубины резкости часто некачественно выполняет свою работу. У трехмерного объекта в фокусе зачастую размыты границы, потому что его глубина на границе будет отличаться от той, что в самом центре фокусировки. Также размытие может казаться неестественным, так как на смартфонах обычно применяется равномерное размытие, а не усиливающееся в зависимости от расстояния до точки фокуса.

Кроме того, что датчик глубины резкости определяет положение объектов и обеспечивает эффектное размытие на фотографиях, он необходим для следующих функций:

Датчик используется не только для определения глубины резкости во время съемки — его возможности намного шире. Определяя расположение предметов, он поддерживает технологию виртуальной реальности для мобильных пользователей. И если сейчас сенсор работает неидеально, в будущем датчик глубины на телефоне может стать таким же эффективным, как и VR-очки.

Рекомендуем прочитать материал с советами, которые помогут делать красивые снимки на камеру смартфона.

Что делают 3D-сенсоры в смартфонах? РАЗБОР

Все чаще мы видим в смартфонах так называемые 3D-сенсоры, или сенсоры глубины. Большинство из них также называют ToF-сенсорами аналогично одноименной технологии. По слухам, такой сенсор будет установлен и в новом iPhone (там он называется LiDAR, подробнее мы об этом рассказывали в другом материале). Эти сенсоры довольно дорого стоят, но зачем они нужны понятно не всем. Производители уверяют, что сенсоры позволяют делать лучше фото и портреты или добавляют фишки в дополненную реальность. Но так ли это на самом деле?

Сегодня обсудим, зачем нужны 3D-сенсоры в смартфонах, как это работает, ну и конечно, проведем несколько тестов и проверим заявления производителей.

Что такое 3D сенсор (сенсор глубины)

Для начала, давайте разберемся, а что такое 3D-сенсор? Фотокамеры захватывают проекцию окружающего мира на плоскость. По одной лишь фотографии не понять реальный размер объекта — размером ли он с бутылку или с Пизанскую башню. И расстояние до него тоже не понять.

Для того, чтобы понимать реальные размеры объектов на фото, масштабы съемки, отличать, что ближе к камере, а что дальше, и нужны 3D-сенсоры. Они уже давно и активно применяются в робототехнике, автономном транспорте, играх, медицине и много где еще. Более того, наши глаза — это тоже 3D сенсор. При этом, в отличие от LiDAR’а и ToF-сенсоров в смартфонах, глаза — пассивный 3D-сенсор. То есть не излучающий никакого света, а работающий только на основе поступающего света. Только благодаря этому мы можем хоть как-то перемещаться в пространстве и взаимодействовать с окружающими объектами. Теперь 3D-сенсоры появились и в смартфонах.

Как работает ToF?

LiDAR в iPad’е, а также все 3D-сенсоры в Android-смартфонах — это time-of-flight или сокращенно ToF-сенсоры. Они определяют расстояния до объектов вокруг, напрямую измеряя сколько времени понадобится свету, чтобы долететь от камеры до объекта и вернуться обратно. Это очень похоже на эхо в пещере, оно тоже после отражения от стенок возвращается к нам с запаздыванием. Чтобы пролететь 1 метр свету нужно 3 наносекунды, для 1 см — 30 пикосекунд. Вроде бы все понятно. Но есть проблема.

Это очень маленькие промежутки времени. Как камера может такое замерить? Не будет же она делать миллиард кадров в секунду, а потом их сравнивать? Есть 2 основных подхода для решения этой проблемы: dToF (direct ToF) и iToF (indirect ToF). И чтобы вас заинтриговать еще сильнее: абсолютное большинство Android-смартфонов используют как раз iToF сенсоры, тогда как LiDAR в Apple iPad и скорее всего в грядущих iPhone — это редкий представитель семейства dToF сенсоров. Так чем же они отличаются?

iToF — indirect ToF

Начнем с iToF. В таких сенсорах излучатель отправляет высокочастотный модулированный свет, то есть этот свет постоянно включается и выключается с частотой десятки миллионов раз в секунду. За счет того, что свету нужно время для полета до объекта и обратно, фаза, то есть вот это состояние где-то между включенностью и выключенностью, света, вернувшегося в камеру, немного отличается от фазы света в момент отправки. На сенсоре исходный и отраженный обратно от объекта сигналы накладываются друг на друга, и за счет этого определяется сдвиг фаз, который и позволяет понять расстояние до каждой точки объекта.

dToF — direct ToF

dToF работает немного иначе. В таких сенсорах напрямую измеряется разница во времени между отправкой света и детектированием его отражения на сенсоре. Для этого используются так называемые SPAD: single photon avalanche diodes. Они могут детектировать крайне маленькие импульсы света, фактически даже ловить единичные фотоны. Такие SPAD расположены в каждом пикселе сенсора. А в качестве излучателя в таких сенсорах используются как правило так называемые VCSEL — Vertical Cavity, Surface Emitting Laser. Это лазерный излучатель, подобный тем, что используются в лазерных мышках и много где еще. dToF сенсор в LiDAR разработан совместно с Sony и является первым массовым коммерческим dToF сенсором.

Можно лишь гадать, почему в iPad используется dToF сенсор, но давайте отметим преимущества такого сенсора. Во-первых, в отличие от iToF сенсора излучатель испускает не сплошную стену света, а лишь светит в отдельных направлениях, что позволяет экономить батарейку. Во-вторых, dToF сенсор меньше подвержен ошибкам в измерении глубины из-за так называемой multipath interference. Это типичная проблема iToF сенсоров. Она возникает из-за переотражения света между объектами перед попаданием обратно в сенсор и искажает измерения сенсора.

Как это работает, разобрались, давайте теперь посмотрим, а зачем вообще 3D-сенсоры используются в смартфонах.

Зачем это нужно в смартфонах

1. Безопасность

Первым массовым внедрением 3D-сенсоров в смартфонах мы обязаны Apple и технологии Face ID. Распознавание лиц при использовании трёхмерных данных намного точнее и надежнее классического распознавания лиц по фото. Для Face ID Apple использует технологию структурированной подсветки, на ней мы остановимся подробнее как-нибудь в следующий раз.

Большинство производителей заявляют, что именно более качественный и точный режим дополненной реальности является главной задачей 3D-сенсоров. Более того, это также поддерживается непосредственно компанией Google. Буквально недавно они представили грядущее обновление своей библиотеки дополненной реальности ARCore, позволяющее более реалистично размещать виртуальные объекты в реальности и взаимодействовать с реальными объектами.

Для этой же задачи Apple встроили LiDAR в iPad Pro. Такое можно делать и без 3D-сенсора, но с ним все работает точнее и надежнее, плюс задача становится вычислительно сильно проще и разгружает процессор. 3D-сенсор выводит AR на другой уровень.

3. Улучшение фотографий

Ряд производителей, например, Samsung и HUAWEI заявляют, что 3D-сенсор используется в первую очередь для более качественного размытия фона и более точного автофокуса при съемке видео. Другими словами, он позволяет увеличить качество обычных фото и видео.

4. Прочее

Доступ к данным сенсоров у некоторых смартфонов открыт, поэтому появляется все больше приложений, предлагающих новые применения. Так, например, с помощью внешних приложений 3D-сенсор можно использовать для измерения объектов, трехмерного сканирования и motion tracking’а. Есть даже приложение, позволяющее сделать из своего смартфона прибор ночного видения.

Тесты

С тем как это работает в теории разобрались, давайте теперь посмотрим, как это работает на практике, и есть ли какой-то толк от этих дорогущих 3D-сенсоров в флагманах. Для тестов мы взяли Redmi Note 9S, у него есть ToF-сенсор и мы сделали несколько снимков в портретном режиме, но во втором случае просто закрыли 3D-камеру пальцем. И вот что получилось.

Всё просто — размытие действительно больше и лучше, если ToF работает.

И для частоты эксперимента мы взяли Samsung Galaxy S20 Ultra, который также получил ToF-камеру.

И найдите хотя бы одно отличие?

Что получается? Дело в том, что в зависимости от производителя ToF-камера используется по-разному и в разной степени.

Можно сказать, что часть производителей смартфонов располагает ToF-датчики в своих смартфонов не для маркетинга, чтобы добавить ещё одну камеру, а скорее на всякий случай. А дальше уже алгоритмы решают — использовать эту камеру или нет?

При этом на сегодняшний момент необходимости в LiDAR или ToF-камерах прямо нет. Так что это видимо чуть больше маркетинг.

Что такое сенсор глубины на смартфоне? Или почему портретный режим превратился в инструмент для обмана

Каждый раз, делая обзор на очередной смартфон и упоминая «сенсор глубины», я чувствую, что ввожу читателя в заблуждение.

Сегодня этот загадочный датчик глубины встречается на подавляющем большинстве устройств, ведь он так важен для портретного режима с красивым размытием фона (эффект боке, живой фокус, режим диафрагмы и пр.).

А может и не важен вовсе? Возможно, вы встречали на просторах интернета разоблачения, в которых люди полностью заклеивали сенсор глубины, а смартфон продолжал размывать фон на портретных снимках, как ни в чем не бывало. Получается, телефоны умеют определять глубину сцены и без сенсора глубины? Зачем же он тогда нужен?

Ну и главный вопрос — как вообще устроен этот «сенсор»? На чем основан принцип его работы?

Бегло просмотрев несколько популярных статей и роликов в интернете, я с удивлением обнаружил, что многие люди думают, будто этот сенсор посылает световые импульсы и определяет время задержки отраженного луча. То есть, как-то активно участвует в построении карты глубины.

А вот, к примеру, на сайте Popular Science (Популярная наука) приводится следующее объяснение (в моем вольном переводе):

Датчик глубины (depth sensor) предназначен именно для определения глубины сцены. В топовых современных смартфонах датчик глубины постепенно исчезает, так как его заменяют другие камеры, умеющие ощущать глубину и объем сцены, например широкоугольная или телеобъектив.

Камеры, ощущающие глубину — это, конечно, очень интересно, но давайте разберемся, что же происходит на самом деле.

Зачем вообще нужен какой-то сенсор глубины?

Современный смартфон должен не просто «видеть» через камеру плоскую картинку, но и «понимать», на каком расстоянии находится каждый объект в сцене. То есть, он должен уметь «ощущать» глубину сцены. И на это есть целый ряд причин.

Например, благодаря умению построить карту глубины, телефоны научились делать красивые фотографии с размытием фона. Да, часто на таких снимках заметна искусственная обработка, но иногда результат практически не отличим от работы зеркального фотоаппарата:

Сделать что-то подобное при помощи оптики нереально, так как единственный параметр, отвечающий за степень размытия фона — это диаметр входного зрачка объектива (проще говоря, размер дырки, через которую свет попадает в объектив смартфона).

На самых дорогих камерофонах он не превышает и 4 миллиметров, в то время, как даже у бюджетного объектива зеркального фотоаппарата он будет минимум в 2 раза больше (а у дорогих объективов — в 10-15 раз).

Помимо этого, на смартфоны постепенно приходит дополненная реальность (AR), позволяющая определять размеры объектов, расстояние между предметами и делать много всего удивительного (примерять вещи и различные аксессуары, смотреть, как будет выглядеть мебель в интерьере своего дома и многое другое).

Также умение определять глубину позволяет создавать более надежные и удобные способы блокировки смартфона (например, технология FaceID, которая делает «трехмерный» снимок лица).

Многие производители пытаются придумать новые способы управления смартфоном при помощи бесконтактных жестов, а для этого также нужно хорошо понимать положение рук в пространстве.

Но как смартфоны определяют глубину и какие датчики для этого используются?

Три кита

На сегодняшний день существует всего 3 основных метода, позволяющие смартфонам «ощущать» объем:

Открою небольшую тайну. В некоторых смартфонах в качестве всем нам знакомого датчика приближения (тот, который блокирует экран во время входящего звонка) используется самая настоящая ToF-камера с лазерным излучателем и специальным высокочувствительным сенсором, измеряющим время полета света и определяющим точное расстояние до объекта. Работает он, естественно, гораздо точнее и качественнее обычных инфракрасных датчиков, встречающихся на подавляющем большинстве устройств.

Так вот, возвращаясь к нашей теме, горькая правда заключается в том, что для первого метода определения глубины сцены (стереозрение) не нужны дополнительные датчики.

Если на смартфоне уже есть две камеры (например, основная и ультраширокоугольная, или основная и телеобъектив), использовать еще третий «сенсор глубины» (то есть, еще одну камеру) нет никакого смысла.

Дополнительный «сенсор глубины» на 99.9% смартфонов — это банальная попытка ввести покупателя в заблуждение.

Возьмем, к примеру, смартфон Redmi Note 9 Pro, у которого сзади размещено 4 камеры:

Здесь уже есть основная и ультраширокоугольная камеры (две верхние). И этого более, чем достаточно для определения глубины сцены по принципу стерео-зрения. Но компания пытается обмануть покупателя, показав больше камер, чем у конкурентов. И таких примеров масса: Samsung Galaxy A51, Xiaomi Poco X3, OnePlus Nord, Huawei Y8p и мн. др.

Так как «сенсор глубины» — это самая обыкновенная камера с очень низким разрешением, то стоимость такой матрицы составляет от 30 центов за 2 Мп сенсор до 50-60 центов за 5 Мп сенсор (правда, за последний год цены немного выросли из-за колоссального спроса на столь дешевые компоненты).

Производитель за пару баксов может легко набросать пару лишних камер на корпус и затем использовать это количество в качестве конкурентного преимущества, внушая покупателям, что смартфон с пятью камерами снимает ну почти как зеркалка.

Еще раз повторю ключевую мысль прежде, чем мы продолжим: все современные смартфоны, за исключением буквально 10-15 флагманских моделей, определяют глубину сцены при помощи двух обыкновенных камер и метода под названием стереозрение. Да и те 10-15 флагманов также используют в основном стереозрение, а ToF-сенсор служит лишь как дополнительный инструмент.

Многие аппараты (Samsung Galaxy S20/Note20, Huawei P40, iPhone 11 Pro и прочие), легко обходятся основными камерами (широкоугольной, ультраширокоугольной или телеобъективом). Другие же устанавливают дополнительную камеру за три копейки исключительно в маркетинговых целях без малейшей технической необходимости.

А некоторые и вовсе идут на серьезный обман — устанавливают 2-Мп низкокачественную камеру а-ля «сенсор глубины», а сами используют широкоугольную камеру, так как ее качество гораздо выше.

Как смартфон определяет глубину, используя стереозрение и 2 камеры?

Итак, мы определились, что никакого «сенсора глубины» нет. Это обычная (и зачастую — лишняя) камера. Но что же такое стереозрение и как оно работает? Зачем нам нужны две камеры, ведь есть смартфоны, которые умеют размывать фон даже с одной камерой?

Наш мозг использует множество техник для определения глубины и объема сцены, например:

Можно продолжать этот список, но главная причина, по которой мы ощущаем объем, заключается в другом.

У каждого из нас есть два глаза, размещенных на небольшом расстоянии друг от друга. Причем один из них — не запасной и не для красоты или симметрии. Если мы будем смотреть на что-то поочередно то одним, то другим глазом, тогда те объекты, что расположены ближе к нам, будут смещаться в стороны гораздо сильнее тех объектов, что расположены дальше.

Очевидно, что так происходит потому, что правый глаз видит всю сцену как бы с правой стороны, а левый — с левой:

На картинке выше в левом глазу дерево немного сместилось влево, а цветок — вправо. А в правом глазу получилось наоборот — цветок оказался немного левее дерева.

Теперь мозг берет «картинки» из двух глаз и анализирует смещение каждой «точки». Возьмем левый глаз. Чем сильнее точка сместилась вправо (относительно такой же точки в правом глазу), тем ближе она находится к нам и наоборот, чем сильнее сместилась влево — тем она дальше от нас.

Это хорошо видно на следующей анимации, где поочередно меняются картинки, которые увидел левый и правый глаз:

Обратите внимание, как камни в левом нижнем углу смещаются вправо (значит, находятся ближе), в то время, как деревья в правом верхнем углу уходят влево (находятся дальше). Получается, даже меняя поочередно две картинки, мы уже можем ощутить объем.

Вот еще одна наглядная анимация:

Вроде бы всё просто и понятно. Но как же это делает смартфон? Как конкретно он строит карту глубины всей сцены, используя две камеры?

Чтобы разобраться с этим, давайте рассмотрим простой пример.

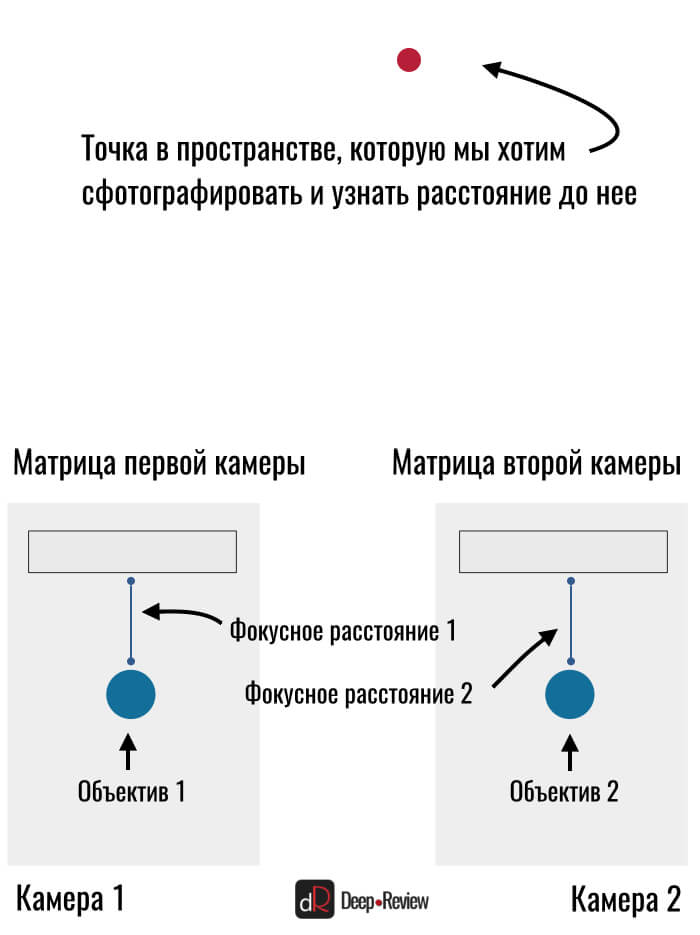

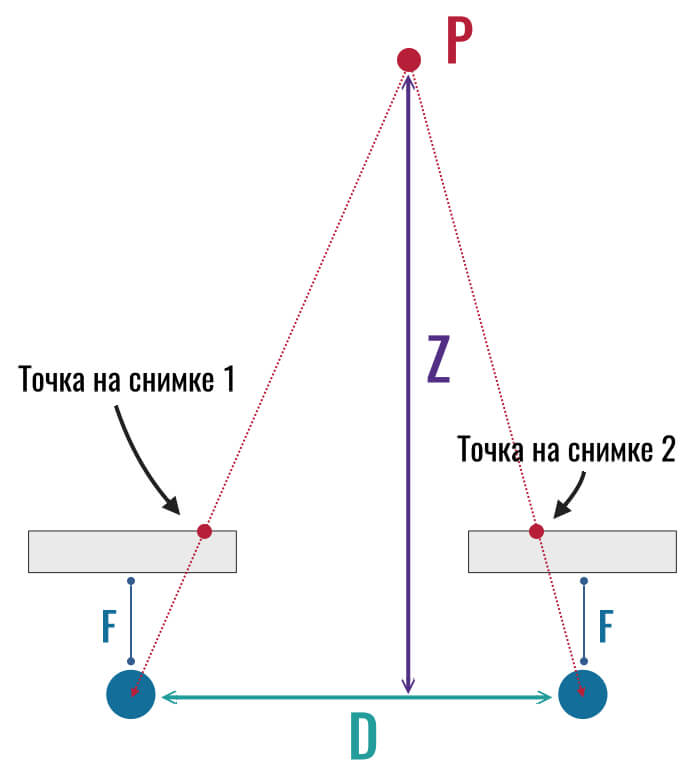

Итак, у нас есть какая-то точка в пространстве и смартфон с двумя камерами. Свет от точки проходит через объектив каждой камеры и попадает на матрицу. Мы получили два плоских снимка этой точки и не можем определить расстояние до нее:

Думаю, вы обратили внимание на одну странность — почему матрица камеры находится перед самой камерой, хотя должна находиться за объективом? На самом деле, мы просто разместили ее так схематически для простоты понимания. Это ни на что не влияет и принцип работы сохраняется.

Нам нужно узнать расстояние до красной точки. Мы знаем только расстояние между двумя камерами (производитель разместил их на определенном расстоянии друг от друга). Также нам известно фокусное расстояние камер, то есть, расстояние от центра линзы до матрицы, на которую она проецирует изображение:

На первый взгляд кажется, что сделать это невозможно и нам ничего не дает знание расстояния между камерами.

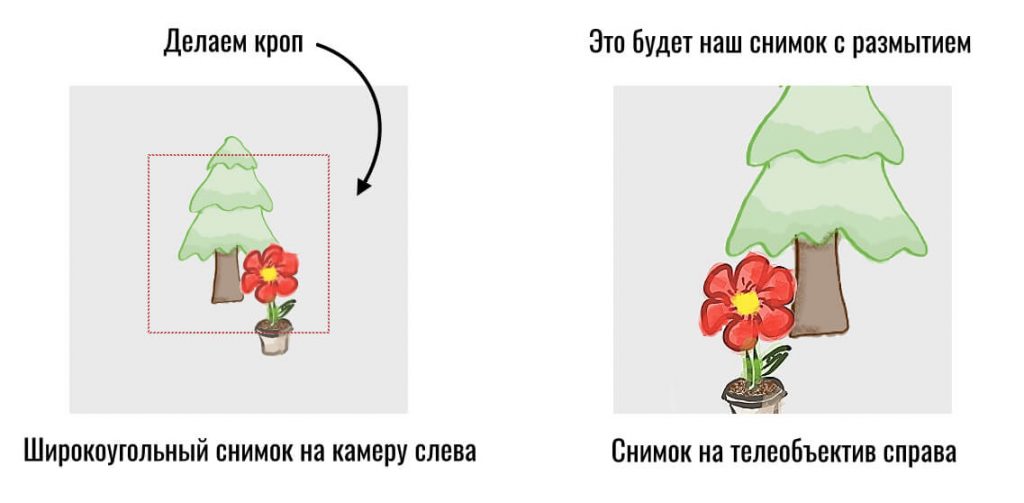

К слову, если мы используем камеры с разными фокусными расстояниями (например широкоугольную и телеобъектив), тогда нужно просто сделать кроп на снимке с более широким углом (вырезать часть кадра) и дальше уже работать, как с идентичным фокусным расстоянием:

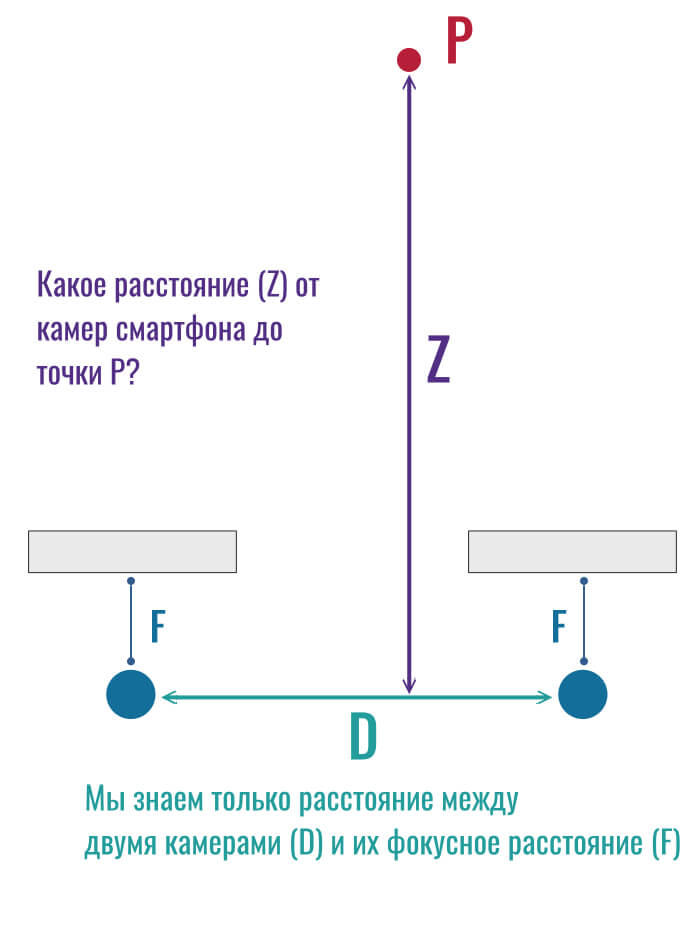

Итак, давайте посмотрим, как свет от красной точки P упадет на наши матрицы и превратится в точки на снимках:

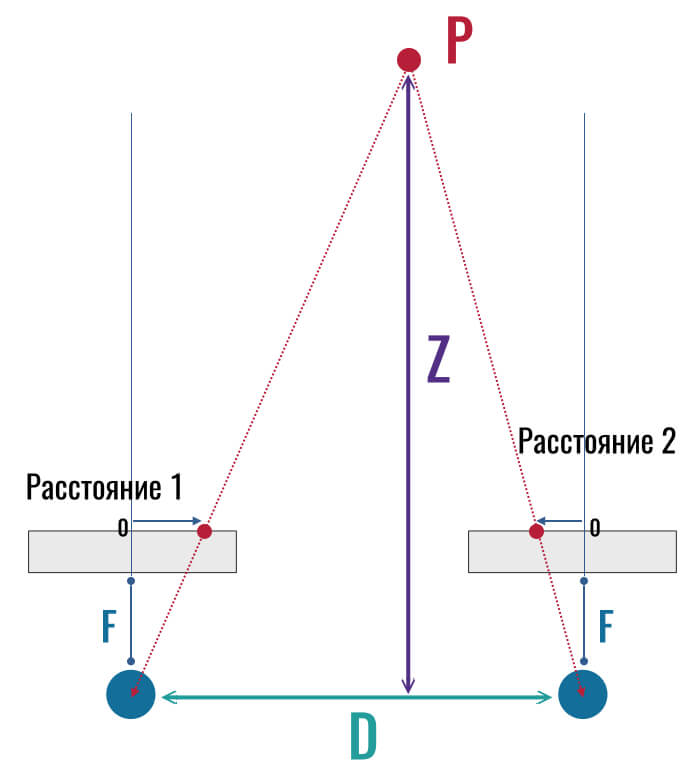

Обратите внимание на то, что точка на левом снимке оказалась справа от центра матрицы, а на правом снимке эта же точка оказалась левее центра. Если бы мы приняли центр за начало отсчета, тогда точка слева ушла бы по горизонтальной оси в плюс (вправо), а справа — в минус (так как центр — это 0):

И как все эти рисунки помогут нам найти расстояние Z (от камеры до точки в пространстве)?

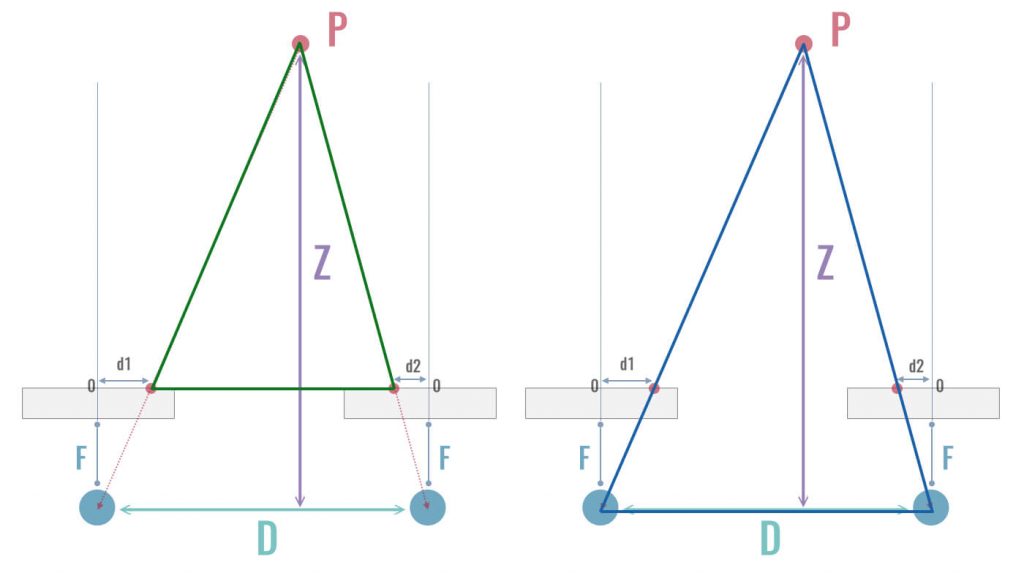

Думаю, вы уже давно заметили, что все эти точки образовывают треугольники. В частности, здесь можно увидеть два подобных треугольника. Один проходит через наши красные точки на двух снимках и точку в пространстве (зеленый треугольник слева), а другой проходит через центры объективов и точку в пространстве (синий треугольник справа):

Эти треугольники подобны, а значит, их стороны соответственно пропорциональны и все углы соответственно равны. И вот уже из этого подобия мы можем легко определить расстояние от камеры до любой точки в пространстве, то есть, найти величину Z.

Я упущу несложные математические расчеты и просто запишу конечный результат:

Z = F * D/(d1-d2)

Здесь F — это фокусное расстояние объектива (известная заранее характеристика нашей камеры), D — расстояние между камерами (также известно), а d1 и d2 — смещение конкретной точки (пикселя) на снимках с левой и правой камер.

Другими словами, смартфон делает ровно то же, что и наш мозг — определяет глубину сцены только по смещению (несоответствию) пикселей на левой и правой фотографии (или на «картинке» в левом и правом глазу).

Получается, всё, что нам нужно — это две (любые) камеры и больше ничего. Соответственно, третья камера («сенсор глубины») совершенно бесполезна.

Но мой смартфон делает превосходные портреты даже с одной камерой!

Некоторые смартфоны действительно могут определять глубину сцены даже с одной камерой. И делается это при помощи искусственного интеллекта.

Опять-таки, смартфон пытается копировать работу нашего мозга. Когда мы смотрим на сцену одним глазом (или двумя глазами смотрим на плоскую фотографию), то легко определяем, какой объект находится дальше, а какой — ближе.

Смартфоны также учатся сегментировать фотографии и выделять на снимках людей. Для этого нужно обучить нейронную сеть отличать человека от других объектов.

Но даже в случае с одной камерой, нейросеть берет дополнительную информацию с двух снимков. Двух снимков?! Но откуда же берется второй снимок, если камера всего одна?

Дело в том, что очень многие современные матрицы имеют фазовый автофокус Dual Pixel. То есть, фактически каждый пиксель на матрице состоит из двух отдельных «пикселей» (фотодиодов), каждый из которых собирает информацию только с половины линзы. Скажем, левый пиксель берет информацию с правой половины линзы, а правый — с левой половины:

Можно сказать, что у нас появляются две камеры (две части одной линзы) с небольшим расстоянием. Да, это крошечное расстояние, но его достаточно, чтобы уже заметить какое-то смещение пикселей.

Вот два примера таких снимков, полученных с двух половин линзы (Dual-Pixel 1 и Dual-Pixel 2) одной камеры:

Как видите, смещение на примере слева более ярко выражено, так как лампочка находится гораздо ближе к камере, нежели человек на втором снимке.

Использование двух камер (то, о чем мы говорили выше) будет давать гораздо большее смещение, чем использование одной камеры с фазовым автофокусом Dual Pixel. Это можно наглядно увидеть на следующем примере (слева — одна камера, но разные части линзы, а справа — две камеры на небольшом расстоянии друг от друга):

Но некоторые смартфоны умудряются делать портретные режимы даже без двух камер или двух изображений с разных половин одной линзы. Правда, качество такого размытия заметно уступает традиционному стереозрению.

Всё, о чем я говорил выше, касается только пассивной технологии определения глубины сцены, когда смартфон просто «смотрит» на мир через камеру/камеры и никак не пытается с ним взаимодействовать.

Однако существует и более продвинутая активная технология, когда смартфон изучает сцену при помощи лазера (ToF-сенсоры и лидары). Но об этом я подробно расскажу как-нибудь в другой раз.

Алексей, глав. редактор Deep-Review

P.S. Не забудьте подписаться в Telegram на первый научно-популярный сайт о мобильных технологиях — Deep-Review, чтобы не пропустить очень интересные материалы, которые мы сейчас готовим!

Как бы вы оценили эту статью?

Нажмите на звездочку для оценки

Внизу страницы есть комментарии.

Напишите свое мнение там, чтобы его увидели все читатели!

Если Вы хотите только поставить оценку, укажите, что именно не так?